A esta altura, toda persona mínimamente informada y que vive en la realidad sabe que detrás de los multimillonarios que controlan el poder, la política y las finanzas globales se esconden ideas francamente estúpidas y dañinas. Detrás de una melange de malas lecturas históricas (particularmente obsesionadas con el Imperio Romano), propuestas antidemocráticas y descarado aprovechamiento de la ingenuidad de sus fanáticos —quienes sueñan con algún día convertirse en uno de ellos cuando apenas si pueden mantener sus necesidades básicas satisfechas o que creen que por medio de no dejar de halagarlos todo el día todos los días lograrán caer en su favor y ganar acceso a un mundo de beneficios— se esconde en realidad ideas mucho más rústicas, simples y, francamente, idiotas. No existe otra forma de definir las ideas que guían a buena parte de los multimillonarios globales que esa: son ideas idiotas, estúpidas, mal cocinadas y que encuentran su origen mayormente en pésimas lecturas de ciencia ficción de baja calidad.

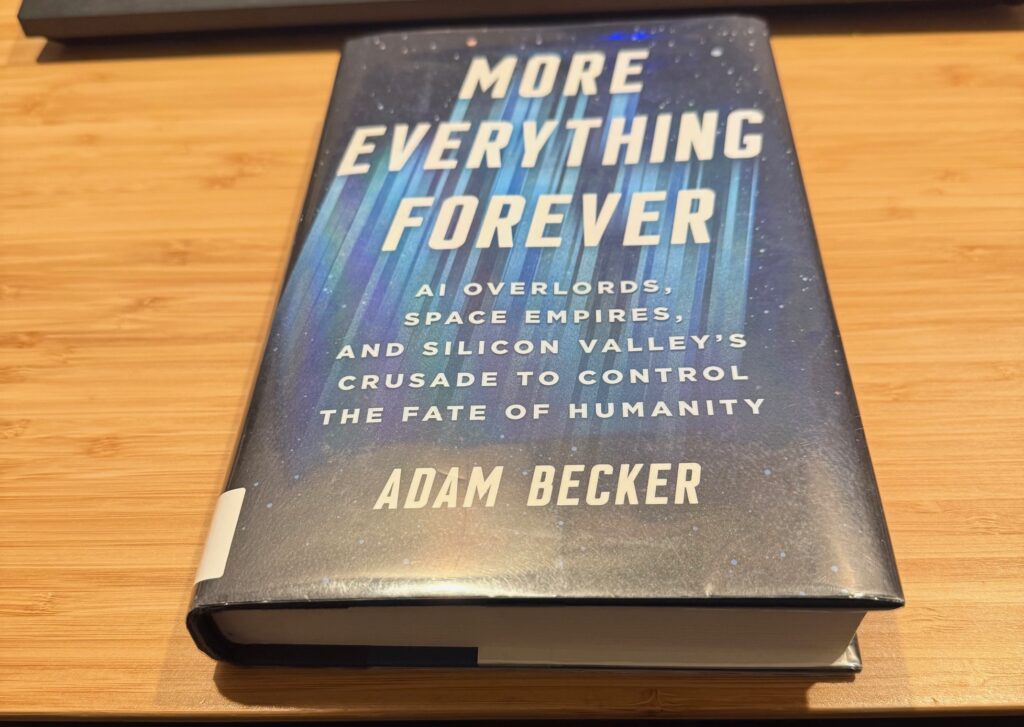

Y si bien esto, como dije, es sabido, hasta ahora no había encontrado una fuente que documentara detalladamente esas mismas ideas idiotas, el modo en el que estos multimillonarios las adoptaron, lo que significan y, en particular, la magnitud de imbecilidad que implican. Todo esto lo encontramos en un reciente libro de Adam Becker, doctor en astrofísica y periodista científico, More Everything Forever: AI Overlords, Space Empires, and Silicon Valley’s Crusade to Control the Fate of Humanity.

A partir de entrevistas con varios personajes que conforman el estrato más ideológico y casi podría decirse religioso del ecosistema de multimillonarios de Sillicon Valley (aunque hay que admitir que, si bien el autor lo intentó, no logró entrevistar a las figuras más globalmente visibles del fenómeno) Becker desarticula con precisión, buena ciencia y bastante sentido del humor las ideas más ridículas que guían a estos sujetos. Como si se tratara de una comedia negra, el autor va comentando situaciones en las que convivió con estos ideólogos o los libros que escribieron, cenas ridículas con inversionistas obnubilados por los productos de software defectuosos y de dudoso uso que producen y tiran al público que no los quiere, pero que aun así logran recibir millonarias inversiones para su desarrollo. Porque si hay algo que aprendimos del capitalismo en este momento histórico es que el consumidor final no le importa a ninguna compañía y que el nuevo cliente son los inversionistas y accionistas.

Detrás de cada idea que podría llegar a presentar sentido o incluso parecer una buena propuesta, como el Effective Alturism (propuesta filosófica contemporánea que propone que deberíamos guiar nuestras acciones para el beneficio de la mayor cantidad posible de gente), el Longtermism (similar a la anterior en cuanto a que propone que debemos actuar de modo tal de garantizar el mejor futuro posible para la humanidad), las promesas de avances tecnológicos como la nanotecnología y formas de extender la vida humana, se desprenden formas pervertidas y ridículas de estas mismas que son las que finalmente estos sujetos adoptan y que, casualmente, se ajustan de modo tal que les permiten encontrar justificaciones filosóficas supuestamente nobles y morales a su escandaloso abuso de poder, saqueo de recursos naturales, sueños imperiales y eugenésicos. El resultado es siempre el mismo: una justificación moral de sus absurdas fortunas y su afán por seguir incrementándolas hacia el infinito.

Algunas de las ideas más estúpidas jamás concebidas

Tomemos, por ejemplo, el Effective Altruism. En principio, podría parecer una idea noble que estos multimillonarios donen sus fortunas a causas que ayuden a la humanidad alrededor del mundo. Sin embargo, detrás de esta mascarada, el Effective Alturism es forzado mediante juegos mentales hacia escenarios inverosímiles que terminan justificando la acumulación de capital. Así, por ejemplo, algunos Effective Alturists de Sillicon Valley se convencen de que deben invertir millones en evitar que se llegue a desarrollar una Inteligencia Artificial General (IAG o AGI según sus siglas en inglés), ya que eso podría llegar a desencadenar la extinción de la humanidad dado que esa inteligencia artificial podría así quererlo. O quizás no quererlo, pero estar programada de modo que ese fuese el resultado. Un ejemplo ridículo que presenta el libro de esta línea de pensamiento sería que se crease una IAG cuyo objetivo fuese crear la mayor cantidad posible de paper clips. Esa IAG eventualmente llegaría a la conclusión de que la única manera de maximizar esa orden sería utilizar todo tipo de materia en el universo (¿?) incluidos los seres humanos. De ese modo, desarrollaría una serie de formas inteligentes para aniquilar a la humanidad y convertirla en paper clips. Esto, que resumo en pocas oraciones, conlleva tantos saltos lógicos y supuestos completamente imposibles de comprobar que no tiene sentido. Este tipo de alturistas, entonces, dedica sus millones a investigar formas de construir barreras para impedir el surgimiento de esas supuestas IAGs homicidas. Podrían, en vez utilizar sus millones en hacer campañas para que los gobiernos alumbren formas de mejorar la distribución de la riqueza, o quizás directamente donar sus fortunas a resolver el hambre en el mundo, alcanzar la paz mundial, o mil otras formas posibles de ayuda material, concreta y directa a la humanidad, como por ejemplo comprar miles de redes atrapa mosquitos para combatir la malaria en África. Todas acciones que sin dudas salvarían millones de vidas y tendrían efectos visibles, reales y concretos. En cambio, estos multimillonarios entienden que el mejor uso de su dinero es seguir haciendo crecer las tecnologías que los convirtieron en multimillonarios, porque una serie de contrafácticos que ellos mismos se crearon en su mente les indica que, de ese modo, favorecerán hipotéticamente a más gente que de cualquier otra forma concreta y real. El potencial es infinito: si colonizamos la galaxia podríamos poblarla con trillones de seres humanos. Siguiendo su línea de pensamiento, si no dedicamos todos los recursos disponibles a colonizar la galaxia, estaríamos condenando a esos trillones de futuros humanos hipotéticos a no existir nunca.

Después, claro, están los que, al contrario, creen que desarrollar una IAG sería el mejor modo de favorecer a la humanidad, ya que podría darnos respuestas a los problemas más acuciantes de nuestra era, como, por ejemplo, ¿cómo resolver la crisis del calentamiento global? Porque es más fácil seguir invirtiendo en máquinas que consumen recursos naturales y empeoran el calentamiento global pero que les llenan los bolsillos a estos sujetos antes que aceptar que la respuesta ya la tenemos sin necesidad de que nos la diga ninguna máquina: debemos cortar las emisiones de carbono a la atmósfera.

Otra idea ridícula, claramente salida de la mente poco desarrollada de un lector de ciencia ficción barata (y no es por despreciar la ciencia ficción a la que amo, ya sea la barata o la no barata, sino a esta gente que la leyó y no la comprendió) es la del “Basilisco de Roko” o “Roko’s Basilisk.” Este contrafáctico, que es simpático como una idea para un cuento de ciencia ficción, aunque ya lo haya hecho antes y mejor Harlan Ellison, propone que si se desarrollase un día una IAG y esta resultara maligna, sabría quiénes colaboraron para su desarrollo y quiénes no, y entonces castigaría con torturas y tormentos interminables a todos aquellos que no hayan hecho nada para desarrollarla. ¿Por qué y cómo sabría una IAG quién colaboró y quién no colaboró en su desarrollo? No importa. ¿Por qué sería maligna la IAG? No importa. ¿Por qué una inteligencia superior estaría preocupada por castigar y torturar a seres insignificantes de inteligencia inferior? Tampoco importa. Esta idea, que, como digo, haría un cuento de ciencia ficción al menos mediocre, se ha convertido en una idea aterradora al punto de generar ataques de psicosis en los seguidores de estos agujeros de gusano del pensamiento podrido que circulan en internet.

El libro muestra más ejemplos: la necesidad de expandir a la humanidad por el espacio, la necesidad de utilizar toda la energía del universo (¿?) para crear una especie de fascismo intergaláctico, la necesidad de colonizar Marte o la luna porque, en definitiva, el planeta en el que vivimos ya está jodido y cualquier cosa antes que desinvertir, pensar en un sistema económico más justo y ecológicamente viable. Pero, como también dije, Becker es doctor en astrofísica y se toma el tiempo y el didactismo para explicar por qué las ideas de colonias espaciales en Marte, la luna o estaciones espaciales flotantes son completamente imposibles de realizar de acuerdo a nuestro conocimiento científico y tecnológico actual.

Como toda comedia negra, el libro deja un sabor un poco agridulce: por una parte, es satisfactorio el modo en el que desenmascara a estos vendedores de espejitos de colores, quienes mayormente no se hicieron multimillonarios por su extraordinaria inteligencia, como quieren hacerle creer al mundo entero, sino por su habilidad para moverse en el mundo de los negocios de Silicon Valley, vender mentiras y exageraciones a los crédulos y, en muchas ocasiones, simplemente haber estado en el lugar indicado en el momento indicado. Por otra parte, deja un sabor amargo precisamente el hecho de confirmar que estos sujetos sostienen y, en algunos casos, creen auténticamente en las ideas más ridículas y estúpidas capaces de ser concebidas por alguien a niveles religiosos. Una religión de ricos que les permite seguir acumulando riqueza, dañando el planeta en el que todos vivimos, y empeorando en general la vida del 99% de la humanidad con la conciencia tranquila por creer que en realidad están salvando a la humanidad. Quizás no a la que vive y respira hoy en día, sino a la hipotética, que bien parece encaminarse a no existir si el calentamiento global termina de destruir la viabilidad de la vida en la Tierra acá y ahora.